Распознавание образов с помощью неординарного алгоритма и программной реализации, осуществляющей функционирование новой разделенной структуры искусственной нейронной сети

Содержание

1.

Теоретическая часть

.1 Цель

работы

.2 Научная

новизна

.3 Мозг и биологический нейрон

.4 Биологический нейрон и нейронные сети

.5 Аналогия между компьютером и

человеческим мозгом

.6

Искусственные нейронные сети

.7 Этапы развития искусственных

нейронных сетей

.8

Архитектура искусственных нейронных сетей

. Проблема

классификации данных

.1

Рецепторная структура восприятия информации

.2 Понятие

класса

.3 Проблема

кластеризации данных

.4

Геометрический и структурный подходы

.5 Гипотеза

компактности

.6 Обучение,

самообучение и адаптация

.7 Подготовка

данных для обучения

2.7.1

Максимизация энтропии как цель предобработки

.7.2

Нормировка данных

2.8

Алгоритмические построения

.9 Обучение

искусственных нейронных сетей

2.9.1

Обучение с учителем

.9.2 Обучение

без учителя

.9.3 Процесс

обучения нейронных сетей

.9.4 Алгоритм

секущих плоскостей

2.10 Обучение

сети Кохонена

.11 Клеточный

автомат в нейронных сетях

2.11.1

Устройство клеточного автомата

2.11.2

Клеточная нейронная сеть

3.

Классификация данных

.1 Постановка задачи и сложности,

связанные с ее реализацией

3.1.1 Выбор

топологии сети

3.2 Алгоритм

кластеризации данных

.3 Блок схема

нейронной сети

.4 Создание

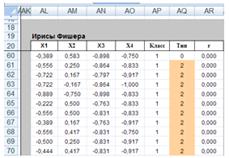

табличной модели нейронной сети Кохонена

3.4.1 Рабочий

лист "Выборки"

.4.2 Рабочий

лист "Обучение"

3.5 Обучение

сети

.6 Создание

табличной модели обученной сети

.7

Тестирование сети

.8 Создание,

обучение и тестирование сети Кохонена в Matlab

3.8.1

Обоснование выбора среды для создания сети

.8.2

Архитектура сети

.8.3 Создание

сети

.8.4 Обучение

сети

.8.5 Тестирование

сети

3.9 Сравнение

результатов кластеризации в Matlab и Excel

Заключение

Список

литературы

1.

Теоретическая часть

.1 Цель

работы

Целью диссертации является разработка нового детерминированного алгоритма

обучения ИНС Кохонена с использованием непрерывного клеточного автомата,

позволяющего устранить большинство перечисленных недостатков, и его

практическая реализация в электронных таблицах.

Для достижения этой цели в работе поставлены и решены следующие задачи:

сбор и ввод нормализованных выборок данных, состоящих из двухмерных и

четырех мерных векторов;

исследование и анализ методов обучения для выявления математических

закономерностей и свойств, применимых в ИНС;

построение графиков и диаграмм, определяющих степень сравнительной

удаленности между различными объектами;

формирование пошагового алгоритма и графической блок-схемы ИНС;

достижение высокого результата классификации при минимальном количестве

образцов из каждого набора;

моделирование, тестирование и отладка программной реализации комплексной

структурной модели ИНС, использующей клеточный автомат;

сравнение параметров обучение с уже существующими аналогами.

Методы исследования.

В работе использованы теория искусственных самоорганизующихся нейронных

сетей для графических массивов базы данных с применением процесса распознавания

без учителя, статистический анализ, теория множеств и

кластеризации/категоризации объектов, методы алгоритмизации, методы

компьютерного моделирования в VBA для Excel и создание нейронной сети на основе

MS Excel, а также среда Matlab.

1.2 Научная

новизна

Имеющиеся в арсенале алгоритмы классификации в основном используют

неадаптивные алгоритмы распознавания образцов, которые работают для небольшого

количества обучаемых образцов. Значительное увеличение обучающей выборки

приводит к большому увеличению трудоемкости обучения. На основе проведенных

исследований в настоящей работе предложена новая и эффективная методика

распознавания образцов с помощью разделенной схемы искусственной нейронной сети

без учителя на основе клеточного автомата не только для двумерных, но и для

четырехмерных векторов. Научная новизна заключается в формулировании методики и

создании нового, адаптивного алгоритма, с использованием разделенной

искусственной нейронной сети без учителя и параллельного

вероятностно-статистического анализа информации.

.3 Мозг и

биологический нейрон

Мозг (рис. 1.1а) и Центральный Процессор (ЦП) ЭВМ (рис. 1.1б), являются

самыми сложными системами переработки информации. ЦП интегрирует миллионы

полупроводниковых транзисторов и подобен мозгу, в котором содержится около 100

миллиардов нейронов, каждый из которых имеет в среднем 10000 связей. По

аналогии с схемотехникой больших интегральных схем (БИС) ЭВМ, где происходит

прием, передача и переработка цифровой информации, биологическая сеть нейронов

отвечает за все явления, которые мы называем мыслями, эмоциями, памятью,

сенсомоторными и автономными функциями.

Рис. 1.1а. Строение и функции головного мозга

Рис. 1.1б. Пример схемы ЦП

Мозг, в котором, в отличие от ЦП, ежедневно погибает большое количество

нейронов, чрезвычайно надежен и продолжает функционировать. Обработка огромных

объемов информации мозгом осуществляется очень быстро, за доли секунды,

несмотря на то, что сам нейрон является медленнодействующим элементом со

временем реакции нескольких миллисекунд.

В отличие от биологического нейрона, электрические полупроводники ЦП

являются более быстродействующими и безошибочными, однако количество связей

между нейронами мозга во много раз превышает связи между полупроводниками ЦП,

что обеспечивает параллелизм и много поточность обработки информации. Головной

мозг человека состоит из серого и белого вещества. Серое вещество представляет

собой сеть дендритов, аксонов и тел нервных клеток. Миелинизированные волокна,

соединяющие различные области мозга друг с другом, с органами чувств и

мускулами, образуют белое вещество. Мозг состоит из двух полушарий, каждое

полушарие в свою очередь из четырех частей - лобной, теменной, височной и

затылочной.

В лобной части находится отдел эмоций и центры управления движениями -

правое полушарие отвечает за движение левой руки и ноги, а левое за движение

правой руки и ноги. В теменной части - зона телесных ощущений и осязаний. К ней

примыкает височная зона, в которой расположены центр речи, слуха, вкуса. В

затылочной части расположен зрительный отдел, также отдел распознавания

окружающих предметов посредством зрения. В мозге существуют структурно

обособленные отделы такие, как кора, гипоталамус, мозжечок, миндалина,

полосатое тело и т. д. Каждый из отделов, в свою очередь, имеет сложное

модульное строение. Особое место в мозге зажимает церебральная кора.

Считается, что именно здесь происходят важнейшие процессы ассоциативной

переработки информации. Мозг является основным потребителем энергии тела.

Включая в себя лишь 2% массы тела, в состоянии покоя, мозг использует

приблизительно 20% кислорода тела. Мозг также содержит густую сеть кровеносных

сосудов, которые обеспечивают кислородом и питательными веществами нейроны и

другие ткани. Эта система кровоснабжения связана с главной системой

кровообращения посредством высокоэффективной фильтрующей системы, называемой

гематоэнцефалическим барьером, являющимся механизмом защиты, предохраняющим

мозг от возможных токсичных веществ, находящихся в крови.

Защита обеспечивается низкой проницаемостью кровеносных сосудов мозга, а

также плотным перекрытием глиальных клеток, окружающих нейроны. Фактически весь

объем мозга, не занятый нейронами и кровеносными сосудами, заполнен глиальными

клетками, которые обеспечивают структурную основу мозга.

1.4

Биологический нейрон и нейронные сети

Каждый нейрон обладает многими качествами, общими с другими элементами

тела, но его уникальной способностью является прием, обработка и передача

электрохимических сигналов по нервным путям, которые образуют коммуникационную

систему мозга. На рис. 1.2а и рис. 1.2б. показана структура и строение типичных

биологических нейронов. Нейрон состоит из трех частей: тела клетки, дендритов и

аксона, каждая часть со своими, но взаимосвязанными функциями. Дендриты идут от

тела нервной клетки (сома) к другим нейронам, где они принимают сигналы в

точках соединения, называемых синапсами.

Принятые синапсом входные сигналы подводятся к телу нейрона. Здесь они

суммируются, причем одни входы стремятся возбудить нейрон, другие -

воспрепятствовать его возбуждению. Когда суммарное возбуждение в теле нейрона

превышает некоторый порог, нейрон возбуждается, посылая по аксону сигнал другим

нейронам. У этой основной функциональной схемы много усложнений и исключений,

тем не менее большинство искусственных нейронных сетей моделируют лишь простые

свойства.

Рис. 1.2а. Структура типичных биологических нейронов

Рис. 1.2б. Строение типичных биологических нейронов

Нервные клетки, или нейроны, представляют собой особый вид клеток в живых

организмах, обладающих электрической активностью, основное назначение которых

заключается в оперативном управлении организмом. Сома, как правило, имеет

поперечный размер несколько десятков микрон. Длина дендритов может достигать 1

мм, дендриты сильно ветвятся, пронизывая сравнительно большое пространство в

окрестности нейрона. Длина аксона может достигать сотен миллиметров. На соме и

на дендритах располагаются окончания (коллатерали) аксонов, идущих от других

нервных клеток. Каждое такое окончание имеет вид утолщения, называемого

синаптической бляшкой, или синапсом. Поперечные размеры синапса, как правило,

не превышают нескольких микрон, чаще всего эти размеры составляют около 1 мкм.

Входные сигналы дендритного дерева (постсинаптические потенциалы)

взвешиваются и суммируются на пути к аксонному холмику, где генерируется

выходной импульс (спайк) или пачка импульсов. Его наличие (или интенсивность),

следовательно, является функцией взвешенной суммы входных сигналов. Выходной

сигнал проходит по ветвям аксона и достигает синапсов, которые соединяют аксоны

с дендритными деревьями других нейронов. Через синапсы сигнал трансформируется

в новый входной сигнал для смежных нейронов. Этот входной сигнал может быть

положительным и отрицательным (возбуждающим или тормозящим) в зависимости от

вида синапсов. Величина входного сигнала, генерируемого синапсом, может быть

различной даже при одинаковой величине сигнала, приходящего в синапс. Эти

различия определяются эффективностью или весом синапса. Синаптический вес может

изменяться в процессе функционирования синапса. Нейроны можно разбить на три

большие группы: рецепторные, промежуточные и эффекторные. Рецепторные нейроны

обеспечивают ввод в мозг сенсорной информации. Они трансформируют сигналы,

поступающие на органы чувств (оптические сигналы в сетчатке глаза, акустические

в ушной улитке или обонятельные в хеморецепторах носа), в электрическую

импульсацию своих аксонов. Эффекторные нейроны передают приходящие на них

сигналы исполнительным органам. На конце их аксонов имеются специальные

синаптические соединения с исполнительными органами, например мышцами, где

возбуждение нейронов трансформируется в сокращения мышц. Промежуточные нейроны

осуществляют обработку информации, получаемой от рецепторов, и формируют

управляющие сигналы для эффекторов. Они образуют центральную нервную систему.

.5 Аналогия

между компьютером и человеческим мозгом

Основные положения теории деятельности головного мозга и математическая

модель нейрона были разработаны У. Мак-Каллоком и Ч. Питтсом в 1943 году.

Согласно предложенной модели мозг представляет собой множество нейронов,

имеющих одинаковую структуру. Каждый нейрон реализует некоторую функцию,

называемую пороговой, над входными значениями. Если значение функции превышает

определенную величину - порог (что характеризует суммарную значимость

полученной нейроном информации), нейрон возбуждается и формирует выходной

сигнал для передачи его другим нейронам. Пройдя путь от рецепторов (слуховых,

зрительных и других) через нейронные структуры мозга до исполнительных органов,

входная информация преобразуется в набор управляющих воздействий, адекватных

ситуации.

Отдельные нейроны, соединяясь между собой, образуют новое качество,

которое, в зависимости от характера межнейронных соединений, имеет различные

уровни биологического моделирования:

группа нейронов;

нейронная сеть;

нервная система;

мыслительная деятельность;

мозг.

Существует подобие между мозгом и цифровым компьютером: оба оперируют

электронными сигналами, оба состоят из большого количества простых элементов,

оба выполняют функции, являющиеся, грубо говоря, вычислительными, тем не менее,

существуют и фундаментальные отличия. По сравнению с микросекундными и даже

наносекундными интервалами вычислений современных компьютеров нервные импульсы

являются слишком медленными. Хотя каждый нейрон требует наличия миллисекундного

интервала между передаваемыми сигналами, высокая скорость вычислений мозга

обеспечивается огромным числом параллельных вычислительных блоков, причем

количество их намного превышает доступное современным ЭВМ. Диапазон ошибок

представляет другое фундаментальное отличие: ЭВМ присуща свобода от ошибок,

если входные сигналы безупречно точны и ее аппаратное и программное обеспечение

не повреждены. Мозг же часто производит лучшее угадывание и приближение при

частично незавершенных и неточных входных сигналах. Часто он ошибается, но

величина ошибки должна гарантировать наше выживание в течение миллионов лет.

Эти две системы явно различаются в каждой своей части. Они оптимизированы для

решения различных типов проблем, имеют существенные различия в структуре и их

работа оценивается различными критериями.

Развитие искусственных нейронных сетей вдохновляется биологией. Структура

искусственных нейронных сетей была смоделирована как результат изучения человеческого

мозга. Искусственные нейронные сети чрезвычайно разнообразны по своим

конфигурациям, функциональности и целевому назначению. Рассматривая сетевые

конфигурации и алгоритмы, исследователи мыслят их в терминах организации

мозговой деятельности, но на этом аналогия может и закончиться. Сходство между

ними очень незначительно, однако, даже эта скромная эмуляция мозга дает

ощутимые результаты.

Например, искусственные нейронные сети имеют такие аналогичные мозгу

свойства, как способность обучаться на опыте, основанном на знаниях, делать

абстрактные умозаключения и совершать ошибки, что является более характерным

для человеческой мысли, чем для созданных человеком компьютеров. Разработчикам

сетей приходится выходить за пределы современных биологических знаний в поисках

структур, способных выполнять полезные функции. Во многих случаях это приводит

к необходимости отказа от биологического правдоподобия, мозг становится просто

метафорой, и создаются сети, невозможные в живой материи или требующие

неправдоподобно больших допущений об анатомии и функционировании мозга.

В настоящее время возникли и остаются две взаимно обогащающие друг друга

цели нейронного моделирования: первая - понять функционирование нервной системы

человека на уровне физиологии и психологии и вторая - создать вычислительные

системы (искусственные нейронные сети), выполняющие функции, сходные с

функциями мозга. Нейроны можно моделировать довольно простыми автоматами, а вся

сложность мозга, гибкость его функционирования и другие важнейшие качества определяются

связями между нейронами.

Каждая связь представляется как простой элемент, служащий для передачи

сигнала и его линейного усиления или ослабления.

Существует большой класс задач: нейронные системы ассоциативной памяти,

статистической обработки, фильтрации и другие, для которых связи формируются по

определенным формулам, при этом обучение нейронных сетей оказалось осуществимым

при моделировании задач на обычных персональных компьютерах.

.6

Искусственные нейронные сети

Сегодня, как и сто лет назад, несомненно, что мозг работает более

эффективно и принципиально другим образом, чем любая вычислительная машина,

созданная человеком. Именно этот факт в течение стольких лет побуждает и

направляет работы ученых всего мира по созданию и исследованию искусственных

нейронных сетей (ИНС).

К первым попыткам раскрыть секрет высокой эффективности мозга можно

отнести работу Рамон-и-Кахаля (1911), в которой была высказана идея о нейроне

как структурной единице мозга. Однако нейрон имеет на 5-6 порядков меньшую скорость

срабатывания, чем полупроводниковый логический элемент. Как показали более

поздние исследования, секрет высокой производительности мозга заключается в

огромном количестве нейронов и массивных взаимосвязях между ними.

Сеть нейронов, образующая человеческий мозг, представляет собой

высокоэффективную, комплексную, нелинейную, существенно параллельную систему

обработки информации. Она способна организовать свои нейроны таким образом,

чтобы реализовать восприятие образа, его распознание или управление движением,

во много раз быстрее, чем эти задачи будут решены самыми современными

компьютерами.

ИНС является упрощенной моделью мозга. Она строится на основе

искусственных нейронов, которые обладают тем же основным свойством, что и

живые: пластичностью. Использование структуры мозга и пластичности нейронов

делает ИНС универсальной системой обработки информации. В общем случае ИНС -

это машина, моделирующая способ работы мозга. Обычно ИНС реализуются в виде

электронных устройств или компьютерных программ. Среди многих можно выделить

определение ИНС как адаптивной машины, данное в: искусственная нейронная сеть -

это существенно параллельно распределенный процессор, который обладает

естественной склонностью к сохранению опытного знания и возможностью

предоставления его нам. Она сходна с мозгом в двух аспектах: знание

приобретается сетью в процессе обучения, для сохранения знания используются

силы межнейронных соединений, называемые также синаптическими весами.

Процедура, используемая для осуществления процесса обучения, называется

алгоритмом обучения. Ее функция состоит в модификации синаптических весов ИНС

определенным образом так, чтобы она приобрела необходимые свойства.

Модификация весов является традиционным способом обучения ИНС. Такой

подход близок к теории адаптивных линейных фильтров, которые уже давно и

успешно применяются в управлении. Однако для ИНС существует еще и возможность

модификации собственной топологии, основывающаяся на том факте, что в живом

мозге нейроны могут появляться, умирать и менять свои связи с другими

нейронами.

Из сказанного выше становится ясно, что ИНС реализуют свою вычислительную

мощь, благодаря двум основным своим свойствам: существенно параллельно

распределенной структуре и способности обучаться и обобщать полученные знания.

Под свойством обобщения понимается способность ИНС генерировать правильные

выходы для входных сигналов, которые не были учтены в процессе обучения

(тренировки). Эти два свойства делают ИНС системой переработки информации,

которая решает сложные многомерные задачи, непосильные другим техникам.

С точки зрения машинного обучения, нейронная сеть представляет собой

частный случай методов распознавания образов, дискриминантного анализа, методов

кластеризации и т.п. С математической точки зрения, обучение нейронных сетей -

это многопараметрическая задача нелинейной оптимизации. С точки зрения

кибернетики, нейронная сеть используется в задачах адаптивного управления и как

алгоритмы для робототехники. С точки зрения развития вычислительной техники и

программирования, нейронная сеть - способ решения проблемы эффективного

параллелизма. А с точки зрения искусственного интеллекта, ИНС является основой

философского течения коннективизма и основным направлением в структурном

подходе по изучению возможности построения (моделирования) естественного

интеллекта с помощью компьютерных алгоритмов.

Нейронные сети не программируются в привычном смысле этого слова, они

обучаются. Возможность обучения - одно из главных преимуществ нейронных сетей

перед традиционными алгоритмами. Технически обучение заключается в нахождении

коэффициентов связей между нейронами. В процессе обучения нейронная сеть

способна выявлять сложные зависимости между входными данными и выходными, а

также выполнять обобщение. Это значит, что, в случае успешного обучения, сеть

сможет вернуть верный результат на основании данных, которые отсутствовали в

обучающей выборке, а также неполных и/или "зашумленных", частично

искаженных данных.

Искусственная нейронная сеть (ИНС, нейронная сеть) - это набор нейронов,

соединенных между собой. Как правило, передаточные функции всех нейронов в

нейронной сети фиксированы, а веса являются параметрами нейронной сети и могут

изменяться. Некоторые входы нейронов помечены как внешние входы нейронной сети,

а некоторые выходы - как внешние выходы нейронной сети. Подавая любые числа на

входы нейронной сети, мы получаем какой-то набор чисел на выходах нейронной

сети. Таким образом, работа нейронной сети состоит в преобразовании входного

вектора в выходной вектор, причем это преобразование задается весами нейронной

сети.

Искусственная нейронная сеть это совокупность нейронных элементов и

связей между ними (рис. 1.3).

Основу каждой искусственной нейронной сети составляют относительно

простые, в большинстве случаев - однотипные, элементы (ячейки), имитирующие

работу нейронов мозга (далее под нейроном мы будем подразумевать искусственный

нейрон, ячейку искусственной нейронной сети).

Рис. 1.3. Искусственный нейрон

Нейрон обладает группой синапсов - однонаправленных входных связей,

соединенных с выходами других нейронов. Каждый синапс характеризуется величиной

синоптической связи или ее весом.

Каждый нейрон имеет текущее состояние, которое обычно определяется, как

взвешенная сумма его входов:

Нейрон имеет аксон - выходную связь данного нейрона, с которой сигнал

(возбуждения или торможения) поступает на синапсы следующих нейронов. Выход

нейрона есть функция его состояния:

= f(s)

Функция f называется функцией активации (рис. 1.4).

Рис.1.4 . Функция активации

Функция активации может иметь разный вид:

пороговый (рис. 1.4a),

кусочно-линейный (рис. 1.4б),

пигмоид (рис. 1.4в, 1.4г).

Множество всех нейронов искусственной нейронной сети можно разделить на

подмножества - т.н. слои. Взаимодействие нейронов происходит послойно.

Слой искусственной нейронной сети - это множество нейронов, на которые в

каждый такт времени параллельно поступают сигналы от других нейронов данной

сети

Выбор архитектуры искусственной нейронной сети определяется задачей. Для

некоторых классов задач уже существуют оптимальные конфигурации. Если же задача

не может быть сведена ни к одному из известных классов, разработчику приходится

решать задачу синтеза новой конфигурации. Проблема синтеза искусственной

нейронной сети сильно зависит от задачи, дать общие подробные рекомендации

затруднительно. В большинстве случаев оптимальный вариант искусственной

нейронной сети получается опытным путем.

Искусственные нейронные сети могут быть программного и аппаратного

исполнения. Реализация аппаратная обычно представляет собой параллельный

вычислитель, состоящий из множества простых процессоров.

1.7 Этапы

развития искусственных нейронных сетей

Если опустить чисто биологический этап, то можно сказать, что современная

эпоха развития ИНС началась в 1943 году с пионерской работы Мак-Каллока и

Питтса. В этой работе Мак-Каллок и Питтс ввели понятие "порогового

логического нейрона" и описали логическую модель ИНС.

В 1948 году была опубликована известная книга Винера

"Кибернетика", описывающая ряд важных концепций управления. В более

поздних изданиях в нее были добавлены разделы, посвященные обучению,

самоорганизации и нейрокибернетике.

Следующим событием, продвинувшим развитие ИНС, стал выход в свет книги

Хебба, в которой впервые было представлено физиологическое обучающее правило

модификации синапсов. Хебб предположил, что соединения в мозге непрерывно

меняются по мере того, как организм обучается новым функциональным задачам, и

что таким образом создаются нейронные ансамбли. Хебб следовал сделанному ранее

предположению Рамон-и-Кахаля и ввел "постулат обучения", который

гласит, что эффективность (усиление) переменного синапса между двумя нейронами

увеличивается в процессе повторяющейся активации одного нейрона другим через

этот синапс.

Книга Хебба стала настоящим источником вдохновения для создания

обучающихся и адаптивных систем. Работы Рочестера, Холланда, Хейбта и Дуде в

1956 г. были, наверное, первыми попытками использовать компьютерное

моделирование для тестирования теории ИНС, базирующейся не постулате обучения

Хебба. Полученные ими результаты показали, что не только активация, но и

торможение должны присутствовать в процессе обучения. В тот же год Уитли

продемонстрировал, что ИНС с модифицируемыми синапсами может быть обучена

классифицировать простые наборы бинарных шаблонов по соответствующим классам. В

более поздней своей работе Уитли также выдвинул гипотезу о том, что

эффективность переменного синапса в нервной системе зависит от статистических взаимоотношений

между изменяющимися состояниями с обеих сторон от синапса, тем самым проведя

связь с информационной теорией Шеннона.

В 1952 году вышла в свет книга Эшби "Design for a Brain: The Origin

of Adaptive Behavior". Одна из главных идей этой книги состоит в том, что адаптивное поведение

живых систем не является наследственным, а скорее появляется в процессе

обучения, и что обычно в процессе обучения поведение живых систем улучшается.

Важным моментом в истории ИНС было написание Минским в 1954 году докторской

диссертации, посвященной ИНС. В 1961 году он опубликовал статью "Steps

Toward Artificial Intelligence", которая была посвящена искусственному

интеллекту и содержала большой раздел, посвященный тому, что сейчас называют

ИНС.

Необходимо отметить огромную важность работ фон Неймана по созданию

цифровых компьютеров для развития всего кибернетического направления. Особое

значение для теории ИНС имела его идея избыточности, которая подтолкнула

Винограда и Коуэна (1963) [14] к созданию распределенного избыточного

представления ИНС.

Примерно 15 лет спустя появления эпохальной статьи Мак-Каллока и Питтса,

в 1958 году Розенблатт в своей работе, посвященной перцептрону [15], предложил

новый подход к решению задачи распознания шаблонов. В ней он ввел так называемую

теорему о сходимости перцептрона, доказательство которой появилось лишь в 1960

году. В 1960 Видроу и Хофф предложили метод наименьших квадратов и использовали

его для описания Adaline. Основное различие между перцептроном и Adaline лежало

в процедурах их обучения.

Одной из первых обучаемых ИНС со слойной структурой был Madaline,

предложенный Видроу и его студентами в 1962 г. Не менее важным событием было

введение в 1967 г. Коуэн сигмоидальной активационной функции для модели

логического нейрона.

В течение классического периода перцептрона 60-х годов казалось, что ИНС

могут делать все. Однако в 1969 г. вышла книга Минского и Пейперта, в которой

строго математически было доказано существование фундаментальных ограничений

возможностей однослойного перцептрона. Также было показано, что однослойная

сеть любой размерности не может решать задачи доступные многослойным

конфигурациям.

Для многослойных перцептронов десятилетие 70-х не принесло ничего нового.

Это было связано отчасти с низким уровнем финансирования работ, отчасти с

отсутствием персональных компьютеров. Негативное влияние оказало также не

подтвердившееся позже мнение об аналогии между спиновыми стеклами и ИНС. С

другой стороны, в это же время были получены значительные результаты в развитии

самоорганизующихся карт на базе соревновательного обучения. В 1976 году фон

Мальсбург и Вильшоу опубликовали первую работу по самоорганизующимся картам,

продемонстрировав действующую самоорганизующуюся ИНС.

С начала 80-х наступил новый период в развитии ИНС. Основными событиями

были разработка Хопфилдом ИНС с полностью связанной структурой и оригинальным

алгоритмом настройки весов. В 1982 в продолжение исследований фон Мальсбурга

выходит работа Кохонена, посвященная самоорганизующимся картам. Но настоящий

прорыв в применении ИНС для решения практических задач (в том числе и

управления) был сделан после того, как в 1986 г. Румельхарт, Хинтон и Вильямс

описали алгоритм обратного распространения. Это был первый эффективный алгоритм

обучения многослойных перцептронов любой структуры (и, как оказалось позже, не

только их).

Интересно, что в еще 1985 г. независимо вышли две работы Паркера и

Ле-Кана с описанием алгоритма обратного распространения. Однако оказалось, что

впервые этот алгоритм был детально описан в 1974 г. в докторской диссертации

Вербоса. К сожалению, тогда на него никто не обратил внимания, и потребовалось

более десяти лет, чтобы эта простая, но изящная схема была переоткрыта.

В 1988 г. произошло последнее на сегодняшний день крупное открытие в

теории ИНС, связанное с введением Брумхедом и Лоуе РБФ-сетей. Это -

альтернативная многослойному перцептрону схема слойной прямонаправленной сети,

использующая скрытые нейроны с радиально-базисной активационной функцией.

Идеологически идея радиально-базисных функции связана с методом потенциальных

функций, предложенным в 1964 г. Башкировым, Браверманом и Мучником. В своих

работах Брумхед и Лоуе не только предложили новый метод синтеза ИНС, но и

уделили огромное внимание установлению связей между ИНС и классическими методами

численного анализа, а также теорией линейных адаптивных фильтров.

.8

Архитектура искусственных нейронных сетей

ИНС может рассматриваться как направленный граф со взвешенными связями, в

котором искусственные нейроны являются узлами. По архитектуре связей ИНС могут

быть сгруппированы в два класса (рис. 1.5): сети прямого распространения, в

которых графы не имеют петель, и рекуррентные сети, или сети с обратными

связями.

Рис. 1.5. Архитектуре связей ИНС

В наиболее распространенном семействе сетей первого класса, называемых

многослойным персептроном, нейроны расположены слоями и имеют однонаправленные

связи между слоями. На рис. представлены типовые сети каждого класса. Сети

прямого распространения являются статическими в том смысле, что на заданный

вход они вырабатывают одну совокупность выходных значений, не зависящих от

предыдущего состояния сети. Рекуррентные сети являются динамическими, так как в

силу обратных связей в них модифицируются входы нейронов, что приводит к

изменению состояния сети.

В общем случае понятие "искусственная нейронная сеть"

охватывает ансамбли нейронов любой структуры, однако практическое применение

нашли только некоторые из них. Это объясняется тем, что архитектура ИНС

непосредственно связана с методом ее обучения. Даже различные этапы развития

ИНС определялись появлением новых архитектур сетей и специально разработанных

для них методов обучения.

Искусственный нейрон (или просто нейрон) является элементарным

функциональным модулем, из множества которых строятся ИНС. Он представляет

собой модель живого нейрона, однако лишь в смысле осуществляемых им

преобразований, а не способа функционирования. Существуют логические,

непрерывные и импульсные [28] модели нейрона. Логические модели нейрона (в частности,

описываемый картой Вена формальный нейрон) активно исследовались в 60-70-х

годах, но не получили дальнейшего развития. Импульсные модели более близки к

физической природе процессов, происходящих в нервной клетке, однако их теория

не так развита как у непрерывных, и они все еще не находят широкого применения.

Нейрон (рис. 1.6) состоит из:

Адаптивный сумматор вычисляет скалярное произведение вектора входного

сигнала на вектор параметров. Адаптивным он называется из-за наличия вектора

настраиваемых параметров. Для многих задач полезно иметь линейную неоднородную

функцию выходных сигналов, для этого добавляют постоянный единичный входной

сигнал.

Нелинейный преобразователь сигнала - получает скалярный входной сигнал и

соответствующим образом его преобразовывает.

Точка ветвления служит для рассылки одного сигнала по нескольким адресам.

Она получает скалярный входной сигнал и передает его всем своим выходам.

Рис. 1.6 Формальный нейрон

Формальный нейрон реализует передаточную функцию:

(1.1)

(1.1)

Из формальных нейронов можно составлять слои нейронов, которые в свою

очередь можно объединять в многослойные сети (рис. 1.7). Нейроны входного слоя

получают сигналы, преобразуют их и через точки ветвления передают нейронам

скрытого слоя. Далее срабатывает следующий слой вплоть до выходного, который

выдает сигналы для интерпретатора и пользователя. Каждый вывод нейронов любого

слоя подается на вход всех нейронов следующего слоя. Число нейронов в слое может

быть любым.

Рис.1.7. Искусственная нейронная сеть

2. Проблема

классификации данных

.1

Рецепторная структура восприятия информации

Для того чтобы человек сознательно воспринял информацию, она должна

пройти довольно длительный цикл предварительной обработки. Вначале свет

попадает в глаз. Пройдя через всю оптическую систему фотоны, в конце концов,

попадают на сетчатку - слой светочувствительных клеток - палочек и колбочек

(рис. 2.1).

Рис. 2.1 Структура зрительного аппарата.

Уже здесь - еще очень далеко от головного мозга, происходит первый этап

обработки информации, поскольку, например, у млекопитающих, сразу за

светочувствительными клетками находится обычно два слоя нервных клеток, которые

выполняют сравнительно несложную обработку.

Теперь информация поступает по зрительному нерву в головной мозг

человека, в так называемые "зрительные бугры", на которые

проецируется зрительная информация то, что мы видим. Далее зрительная информация

поступает в отделы мозга, которые уже выделяют из нее отдельные составляющие -

горизонтальные, вертикальные, диагональные линии, контуры, области светлого,

темного, цветного. Постепенно линии становятся все более сложными и размытыми,

но графический образ пройдет еще долгий путь, прежде чем достигнет уровня

сознания.

К проблеме классификации данных можно подходить, отталкиваясь от аналогии

с биологическими процессами. В некоторых условиях способности животных к

распознаванию превышают способности любой машины, которую только можно

построить.

При классификации, основанной на непосредственном сенсорном опыте, т.е.

при распознавании лиц или произнесенных слов, люди легко превосходят

технические устройства. В "несенсорных ситуациях! действия людей не столь

эффективны. Например, люди не могут соперничать с программами классификации

данных, если правильный класс классификации включает логические комбинации

свойств. Поскольку это должно быть функцией нейронов животного, можно искать

ключ к биологическому распознаванию данных в свойствах самого нейрона. Для

многих целей нейрон можно рассматривать как пороговый элемент. Это значит, что

он либо дает на выходе некоторую постоянную величину, если сумма его входов

достигает определенного значения, либо же остается пассивным. Мак-Каллок и

Питтс доказали, что любую вычислимую функцию можно реализовать с помощью

должным образом организованной сети идеальных нейронов - пороговых элементов,

логические свойства которых с достаточным основанием можно приписать реальному

нейрону. Проблема состоит в том, можно ли найти разумный принцип реорганизации

сети, позволяющий случайно объединенной вначале группе идеальных нейронов

самоорганизоваться в "вычислительное устройство", способное решать

произвольную задачу. Такой принцип реорганизации явился бы теорией обучения,

применимой на уровне отдельного нейрона.

.2 Понятие

класса

Класс - классификационная группировка в системе классификации,

объединяющая определенную группу объектов по некоторому признаку. Образное

восприятие мира - одно из свойств живого мозга, позволяющее разобраться в

бесконечном потоке воспринимаемой информации и сохранять ориентацию в

разрозненных данных о внешнем мире. Воспринимая внешний мир, мы всегда

производим классификацию информации, т.е. разбиваем их на группы похожих, но не

тождественных явлений. Например, несмотря на существенное различие, к одной

группе относятся все буквы "А", написанные различными почерками, или

все звуки, соответствующие одной и той же ноте, взятой в любой октаве и на любом

инструменте. Для составления понятия о группе восприятий достаточно

ознакомиться с незначительным количеством ее представителей. Это свойство мозга

позволяет сформулировать такое понятие, как класс.

Классы обладают характерным свойством, проявляющимся в том, что ознакомление

с конечным числом явлений из одного и того же множества дает возможность

узнавать сколь угодно большое число его представителей.

Классы обладают характерными объективными свойствами в том смысле, что

разные люди, обучающиеся на различном материале наблюдений, большей частью

одинаково и независимо друг от друга классифицируют одни и те же объекты.

Именно эта объективность образов позволяет людям всего мира понимать друг

друга.

Способность восприятия внешнего мира в форме классов позволяет с определенной

достоверностью узнавать бесконечное число объектов на основании ознакомления с

конечным их числом, а объективный характер основного свойства классов позволяет

моделировать процесс их распознавания.

.3 Проблема

кластеризации данных

Классификация - это задача идентификации объекта или определения каких-

либо его свойств по его изображению (оптическое распознавание), числовым

параметрам или аудиозаписи (акустическое распознавание).

В процессе биологической эволюции многие животные с помощью зрительного и

слухового аппарата решили эту задачу достаточно хорошо.

Создание искусственных систем с функциями классификации остаётся сложной

технической проблемой.

Рис. 2.2. Пример объектов обучения.

В целом проблема кластеризации состоит из двух частей: обучения и

кластеризации. Обучение осуществляется путем ввода отдельных векторов с

указанием их принадлежности тому или другому классу. В результате обучения

распознающая система должна приобрести способность реагировать одинаковыми

реакциями на все объекты одного класса и другими реакциями - на все объекты

отличимых классов. Очень важно, что процесс обучения должен завершиться только

путем показов конечного числа объектов. В качестве объектов обучения могут быть

либо векторы (рис. 2.2), либо другие визуальные изображения (буквы, цифры).

Важно, что в процессе обучения указываются только сами объекты и их

принадлежность классу. За обучением следует процесс распознавания новых

объектов, который характеризует действия уже обученной системы. Автоматизация

этих процедур и составляет проблему обучения распознаванию классов. В том

случае, когда человек сам разгадывает или придумывает, а затем навязывает

машине правило классификации, проблема распознавания решается частично, так как

основную и главную часть проблемы (обучение) человек берет на себя.

Круг задач, которые могут решаться с помощью классифицирующих систем,

чрезвычайно широк. Сюда относятся не только задачи распознавания точек и

векторов, но и задачи классификации сложных процессов и явлений, возникающих,

например, при выборе целесообразных действий руководителем предприятия или

выборе оптимального управления технологическими, экономическими, транспортными

или военными задачами. Прежде чем начать анализ какого-либо объекта, нужно получить

о нем определенную, упорядоченную информацию.

Выбор исходного описания объектов является одной из центральных задач

проблемы кластеризации. При удачном выборе исходного описания (пространства

параметров) задача распознавания может оказаться тривиальной и, наоборот,

неудачно выбранное исходное описание может привести либо к очень сложной

дальнейшей переработку информации, либо вообще к отсутствию решения.

.4

Геометрический и структурный подходы

Любой набор данных, который возникает в результате наблюдения какого-либо

объекта в процессе обучения или экзамена, можно представить в виде вектора, а

значит и в виде точки некоторого пространства признаков. Если утверждается, что

при вводе образцов возможно однозначно отнести их к одному из двух (или нескольких)

классов, то тем самым утверждается, что в некотором пространстве существует две

(или несколько) области, не имеющие общих точек, и что класс - точки из этих

областей. Каждой такой области можно приписать наименование, т.е. дать

название, соответствующее классу.

Проинтерпретируем теперь в терминах геометрической картины процесс

обучения классификации данных, ограничившись пока случаем распознавания только

двух векторов. Заранее считается известным лишь только то, что требуется

разделить две области в некотором пространстве, и что показываются точки только

из этих областей. Сами эти области заранее не определены, т. е. нет каких-либо

сведений о расположении их границ или правил определения принадлежности точки к

той или иной области.

В ходе обучения предъявляются точки, случайно выбранные из этих областей,

и сообщается информация о том, к какой области принадлежат предъявляемые точки.

Никакой дополнительной информации об этих областях, т.е. о расположении их

границ, в ходе обучения не сообщается. Цель обучения состоит либо в построении

поверхности, которая разделяла бы не только показанные в процессе обучения

точки, но и все остальные точки, принадлежащие этим областям, либо в построении

поверхностей, ограничивающих эти области так, чтобы в каждой из них находились

только точки одного класса. Цель обучения состоит в построении таких функций от

векторов, которые были бы, например, положительны на всех точках одного и

отрицательны на всех точках другого класса. В связи с тем, что области не имеют

общих точек, всегда существует целое множество таких разделяющих функций, а в

результате обучения должна быть построена одна из них (рис. 2.3).

Если предъявляемые векторы принадлежат не двум, а большему числу классов,

то задача состоит в построении по показанным в ходе обучения точкам

поверхности, разделяющей все области, соответствующие этим классам, друг от

друга. Задача эта может быть решена, например, путем построения функции,

принимающей над точками каждой из областей одинаковое значение, а над точками

из разных областей значение этой функции должно быть различно.

Рис. 2.3. Разделение двух классов в пространстве.

Наряду с геометрической интерпретацией проблемы обучения классификации

существует и иной подход, который назван структурным, или лингвистическим.

Поясним лингвистический подход на примере распознавания зрительных изображений.

Сначала выделяется набор исходных понятий - типичных фрагментов, встречающихся

на изображениях, и характеристик взаимного расположения фрагментов -

"слева", "снизу", "внутри" и т.д. Эти исходные

понятия образуют словарь, позволяющий строить различные логические

высказывания. Задача состоит в том, чтобы из большого количества высказываний,

которые могли бы быть построены с использованием этих понятий, отобрать

наиболее существенные для данного конкретного случая.

Далее, просматривая конечное и по возможности небольшое число объектов из

каждого образа, нужно построить описание этих образов. Построенные описания

должны быть столь полными, чтобы решить вопрос о том, к какому образу

принадлежит данный объект. При реализации лингвистического подхода возникают

две задачи: задача построения исходного словаря, т.е. набор типичных

фрагментов, и задача построения правил описания из элементов заданного словаря.

В рамках лингвистической интерпретации проводится аналогия между

структурой изображений и синтаксисом языка. Стремление к этой аналогии было

вызвано возможностью, использовать аппарат математической лингвистики, т.е.

методы по своей природе являются синтаксическими. Использование аппарата

математической лингвистики для описания структуры изображений можно применять

только после того, как произведена сегментация изображений на составные части,

т.е. выработаны слова для описания типичных фрагментов и методы их поиска.

После предварительной работы, обеспечивающей выделение слов, возникают

собственно лингвистические задачи, состоящие из задач автоматического

грамматического разбора описаний для распознавания изображений. При этом

проявляется самостоятельная область исследований, которая требует не только

знания основ математической лингвистики, но и овладения приемами, которые

разработаны специально для лингвистической обработки изображений.

.5 Гипотеза

компактности

Если предположить, что в процессе обучения пространство признаков

формируется исходя из задуманной классификации, то задание в пространстве

признаков само по себе задает свойство, под действием которого образы в этом

пространстве легко разделяются. Гипотеза компактности гласит: компактным

классам соответствуют компактные множества в пространстве признаков. Под

компактным множеством понимаются некие "сгустки" точек в пространстве

изображений, предполагая, что между этими сгустками существуют разделяющие их

разряжения. Эту гипотезу не всегда удавалось подтвердить экспериментально,

однако те задачи, в рамках которых гипотеза компактности хорошо выполнялась

(рис. 2.3), находилось простое решение. И наоборот, те задачи, для которых

гипотеза не подтверждалась (рис. 2.3), либо совсем не решались, либо решались с

большим трудом. Этот факт заставил, по меньшей мере, усомниться в

справедливости гипотезы компактности, так как для опровержения любой гипотезы

достаточно одного отрицающего ее примера. Вместе с этим, выполнение гипотезы

всюду там, где удавалось хорошо решить задачу обучения классификации, сохраняло

к этой гипотезе интерес. Сама гипотеза компактности превратилась в признак

возможности удовлетворительного решения задач классификации.

Формулировка гипотезы компактности подводит вплотную к понятию абстрактного

класса. Если координаты пространства выбирать случайно, то и векторы в нем

будут распределены случайно. Они будут в некоторых частях пространства

располагаться более плотно, чем в других. В случайно выбранном абстрактном

пространстве почти наверняка будут существовать компактные множества точек.

Поэтому в соответствии с гипотезой компактности множества объектов, которым в

абстрактном пространстве соответствуют компактные множества точек, будут

абстрактными классами данного пространства.

.6 Обучение,

самообучение и адаптация

Обучение - это процесс, в результате которого система постепенно

приобретает способность отвечать нужными реакциями на определенные совокупности

внешних воздействий, а адаптация - это подстройка параметров и структуры

системы с целью достижения требуемого качества управления в условиях

непрерывных изменений внешних условий. Все картинки, представленные на рис.2.2,

характеризуют задачу обучения. В каждой из этих задач задается несколько

примеров (обучающая последовательность) правильно решенных задач. Если бы

удалось подметить некое всеобщее свойство, не зависящее ни от природы классов,

ни от их изображений, а определяющее лишь их способность к разделимости, то

наряду с обычной задачей обучения кластеризации с использованием информации о

принадлежности каждого объекта из обучающей последовательности тому или иному

классу, можно было бы поставить иную классификационную задачу - так называемую

задачу обучения без учителя. Задачу такого рода на описательном уровне можно

сформулировать следующим образом: системе одновременно или последовательно

предъявляются объекты без каких-либо указаний об их принадлежности к классам.

Входное устройство системы отображает множество объектов на множество классов

и, используя некоторое заложенное в нее заранее свойство разделимости классов,

производит самостоятельную классификацию этих объектов. После такого процесса

самообучения система должна приобрести способность к распознаванию не только

уже знакомых объектов (объектов из обучающей последовательности), но и тех,

которые ранее не предъявлялись. Процессом самообучения некоторой системы

называется такой процесс, в результате которого эта система без подсказки

учителя приобретает способность к выработке одинаковых реакций на изображения

объектов одного и того же образа и различных реакций на изображения различных

образов. Роль учителя при этом состоит лишь в подсказке системе некоторого

объективного свойства, одинакового для всех образов и определяющего способность

к разделению множества объектов на образы. Таким объективным свойством является

свойство компактности образов. Взаимное расположение точек в выбранном

пространстве уже содержит информацию о том, как следует разделить множество

точек. Эта информация и определяет то свойство разделимости классов, которое

оказывается достаточным для самообучения системы распознаванию классов.

Обучением обычно называют процесс выработки в некоторой системе той или

иной реакции на группы внешних идентичных сигналов путем многократного

воздействия на систему внешней корректировки. Такую внешнюю корректировку в

обучении принято называть "поощрениями" и "наказаниями".

Механизм генерации этой корректировки практически полностью определяет алгоритм

обучения. Самообучение отличается от обучения тем, что здесь дополнительная информация

о верности реакции системе не сообщается.

Большинство известных алгоритмов самообучения способны выделять только

абстрактные классы, т.е. компактные множества в заданных пространствах.

Различие между ними состоит, в формализации понятия компактности. Результат

самообучения характеризует пригодность выбранного пространства для конкретной

задачи обучения классификации. Если абстрактные классы, выделяемые в процессе

самообучения, совпадают с реальными, то пространство выбрано удачно. Чем

сильнее абстрактные классы отличаются от реальных, тем "неудобнее"

выбранное пространство для конкретной задачи.

Адаптация - это процесс изменения параметров и структуры системы, а

возможно, и управляющих воздействий на основе текущей информации с целью

достижения определенного состояния системы при начальной неопределенности и

изменяющихся условиях работы.

Возможен способ построения классифицирующих машин машин, основанный на

различении каких-либо признаков подлежащих распознаванию фигур. В качестве

признаков могут быть выбраны различные особенности, например, геометрические

свойства (характеристики составляющих фигуры кривых), топологические свойства

(взаимное расположение элементов фигуры) и т.п. Известны кластеризующие машины,

в которых различение производится, по так называемому "методу зондов"

(рис. 2.3), т.е. по числу пересечений контура класса с несколькими особым

образом расположенными прямыми. Если проектировать классы на поле с зондами, то

окажется, что каждый из классов пересекает вполне определенные зонды, причем

комбинации пересекаемых зондов различны для всех классов. Эти комбинации и

используются в качестве признаков, по которым производится различение классов.

Такие машины успешно справляются, например, с чтением машинописного текста, но

их возможности ограничены тем шрифтом (или группой сходных шрифтов), для

которого была разработана система признаков. Работа по созданию набора

эталонных данных или системы признаков должна производиться человеком. Качество

работы машины, т.е. надежность "узнавания" предъявляемых данных

определяется качеством этой предварительной подготовки и без участия человека

не может быть повышено. Описанная машина не являются обучающейся машиной.

Моделирование процесса обучения подразумевает обучение, которому не

предшествует сообщение машине каких-либо сведений о тех кластерах,

распознаванию которых она должна научиться; само обучение заключается в

предъявлении машине некоторого конечного числа объектов каждого кластера. В

результате обучения машина должна оказаться способной узнавать сколь угодно

большое число новых объектов, относящихся к тем же классам. Таким образом,

имеется в виду следующая схема экспериментов:

а) никакие сведения о подлежащих классификации данных в машину заранее не

вводятся;

б) в ходе обучения машине предъявляется некоторое количество объектов

каждого из подлежащих классификации набора данных и (при моделировании процесса

обучения "с учителем") сообщается, к какому классу относится каждый

объект;

в) машина автоматически обрабатывает полученную информацию, после чего

г) с достаточной надежностью различает сколь угодно большое число новых,

ранее ей не предъявлявшихся объектов из классов.

Машины, работающие по такой схеме, называются узнающими машинами.

.7 Подготовка

данных для обучения

При подготовке данных для обучения нейронной сети необходимо обращать

внимание на следующие существенные моменты. Количество наблюдений в наборе

данных. Следует учитывать тот фактор, что чем больше размерность данных, тем

больше времени потребуется для обучения сети. Следует определить наличие

выбросов и оценить необходимость их присутствия в выборке. Обучающая выборка

должна быть представительной (репрезентативной). Обучающая выборка не должна

содержать противоречий, так как нейронная сеть однозначно сопоставляет выходные

значения входным. Нейронная сеть работает только с числовыми входными данными,

поэтому важным этапом при подготовке данных является преобразование и

кодирование данных. При использовании на вход нейронной сети следует подавать

значения из того диапазона, на котором она обучалась. Например, если при

обучении нейронной сети на один из ее входов подавались значения от 0 до 10, то

при ее применении на вход следует подавать значения из этого же диапазона или

близлежащие. Существует понятие нормализации данных. Целью нормализации

значений является преобразование данных к виду, который наиболее подходит для

обработки, т.е. данные, поступающие на вход, должны иметь числовой тип, а их

значения должны быть распределены в определенном диапазоне. Нормализатор может

приводить дискретные данные к набору уникальных индексов либо преобразовывать

значения, лежащие в произвольном диапазоне, в конкретный диапазон, например,

[0..1]. Нормализация выполняется путем деления каждой компоненты входного

вектора на длину вектора, что превращает входной вектор в единичный..

Емкость ИНС - число классов, предъявляемых на входы ИНС для

распознавания. Для разделения множества входных классов, например, по двум

классам достаточно всего одного выхода. При этом каждый логический уровень -

"1" и "0" - будет обозначать отдельный класс. На двух

выходах можно закодировать уже 4 класса и так далее. Для повышения

достоверности классификации желательно ввести избыточность путем выделения

каждому классу одного нейрона в выходном слое или, что еще лучше, нескольких,

каждый из которых обучается определять принадлежность образа к классу со своей

степенью достоверности, например: высокой, средней и низкой. Такие ИНС

позволяют проводить классификацию входных данных, объединенных в нечеткие

(размытые или пересекающиеся) множества. Это свойство приближает подобные ИНС к

условиям реальной жизни.

.7.1

Максимизация энтропии как цель предобработки

Рассмотрим основной руководящий принцип, общий для всех этапов

предобработки данных. Допустим, что в исходные данные представлены в числовой

форме и после соответствующей нормировки все входные и выходные переменные

отображаются в единичном кубе. Задача нейросетевого моделирования - найти

статистически достоверные зависимости между входными и выходными переменными.

Единственным источником информации для статистического моделирования являются

примеры из обучающей выборки. Чем больше бит информации принесет пример - тем

лучше используются имеющиеся в нашем распоряжении данные.

Рассмотрим произвольную компоненту нормированных (предобработанных)

данных. Среднее количество информации, приносимой каждым примером, равно

энтропии распределения значений этой компоненты. Если эти значения

сосредоточены в относительно небольшой области единичного интервала,

информационное содержание такой компоненты мало. В пределе нулевой энтропии,

когда все значения переменной совпадают, эта переменная не несет никакой

информации. Напротив, если значения переменной равномерно распределены в

единичном интервале, информация такой переменной максимальна.

.7.2 Нормировка

данных

Как входами, так и выходами могут быть совершенно разнородные величины.

Очевидно, что результаты нейросетевого моделирования не должны зависеть от

единиц измерения этих величин. А именно, чтобы сеть трактовала их значения

единообразно, все входные и выходные величин должны быть приведены к единому

масштабу. Кроме того, для повышения скорости и качества обучения полезно

провести дополнительную предобработку, выравнивающую распределения значений еще

до этапа обучения.

Индивидуальная нормировка данных.

Приведение к единому масштабу обеспечивается нормировкой каждой

переменной на диапазон разброса ее значений. В простейшем варианте это -

линейное преобразование:

(2.2)

(2.2)

в единичный отрезок [0;1]. Обобщение для отображения данных в интервал

[-1;1], рекомендуемого для входных данных тривиально.

Линейная нормировка оптимальна, когда значения переменной х плотно

заполняют определенный интервал. Но подобный "прямолинейный" подход

применим далеко не всегда. Так, если в данных имеются относительно редкие

выбросы, намного превышающие типичный разброс, именно эти выбросы определят

согласно предыдущей формуле масштаб нормировки. Это приведет к тому, что

основная масса значений нормированной переменной х сосредоточится вблизи нуля.

Гораздо надежнее, поэтому, ориентироваться при нормировке не а экстремальные

значения, а на типичные, т.е. статистические характеристики данных, такие как

среднее и дисперсия.

(2.3)

(2.3)

Где  (2.4)

(2.4)

(2.5)

(2.5)

Единичный масштаб, т.е. типичные значения все переменных будут сравнимы.

Однако, теперь нормированные величины не принадлежат гарантированно

единичному интервалу, более того, максимальный разброс значений заранее не

известен. Для входных данных это может быть и не важно, но выходные переменные

будут использоваться в качестве эталонов для выходных нейронов. В случае, если

выходные нейроны - сигмоидные, они могут принимать значения лишь в единичном диапазоне.

Чтобы установить соответствие между обучающей выборкой и нейросетью в этом

случае необходимо ограничить диапазон изменения переменных.

Линейное преобразование, представленное выше, не способно отнормировать

основную массу данных и одновременно ограничить диапазон возможных значений

этих данных. Естественный выход из этой ситуации - использовать для

предобработки данных функцию активации тех же нейронов. Например, нелинейное

преобразование:

(2.6)

(2.6)

нормирует основную массу данных одновременно гарантируя что значение х

расположено в диапазоне от "1" до "0".

Все выше перечисленные методы нормировки направлены на то, чтобы

максимизировать энтропию каждого входа (выхода) по отдельности. Но, вообще

говоря, можно добиться гораздо большего максимизируя их совместную энтропию.

Существуют методы, позволяющие проводить нормировку для всей совокупности

входов.

.8

Алгоритмические построения

Алгоритмическая универсальность ЭВМ означает, что на них можно программно

реализовывать (т.е. представить в виде машинной программы) любые алгоритмы

преобразования информации, будь то вычислительные алгоритмы, алгоритмы

управления, поиска доказательства теорем, трехмерные графические или аудио

композиции.

Однако не следует думать, что вычислительные машины и роботы могут в

принципе решать любые задачи.

Было строго доказано существование таких типов задач, для которых

невозможен единый и эффективный алгоритм, решающий все задачи данного типа; в

этом смысле невозможно решение таких задач и с помощью вычислительных машин.

Этот факт способствует лучшему пониманию того, что могут делать машины и

чего они не могут сделать.

2.9 Обучение

искусственных нейронных сетей

Среди свойств искусственных нейронных сетей основным является их

способность к обучению, они обучаются самыми разнообразными методами.

Большинство методов обучения исходят из общих предпосылок, и имеет много

идентичных характеристик. Их обучение напоминает процесс интеллектуального

развития человеческой личности. Возможности обучения искусственных нейронных

сетей ограниченны. Тем не менее, уже получены убедительные достижения, такие

как "говорящая сеть" Сейновского, и возникает много других

практических применений. Сеть обучается, чтобы для некоторого множества входов

давать необходимое множество выходов. Каждое такое входное (или выходное)

множество рассматривается как вектор. Обучение осуществляется путем

последовательного предъявления входных векторов с одновременной подстройкой

весов в соответствии с определенной процедурой. В процессе обучения веса сети

постепенно становятся такими, чтобы каждый входной вектор вырабатывал выходной

вектор.

Обычно обучение нейронной сети осуществляется на некоторой выборке. По

мере процесса обучения, который происходит по некоторому алгоритму, сеть должна

все лучше и лучше (правильнее) реагировать на входные сигналы.

Выделяют три парадигмы обучения: с учителем, самообучение и смешанная. В

первом способе известны правильные ответы к каждому входному примеру, а веса

подстраиваются так, чтобы минимизировать ошибку. Обучение без учителя позволяет

распределить образцы по категориям за счет раскрытия внутренней структуры и

природы данных. При смешанном обучении комбинируются два вышеизложенных

подхода.

Существует большое число алгоритмов обучения, ориентированных на решение

разных задач. Среди них выделяет алгоритм обратного распространения ошибки,

который является одним из наиболее успешных современных алгоритмов. Его

основная идея заключается в том, что изменение весов синапсов происходит с

учетом локального градиента функции ошибки. Разница между реальными и

правильными ответами нейронной сети, определяемыми на выходном слое,

распространяется в обратном направлении (рис. 2.4) - навстречу потоку сигналов.

В итоге каждый нейрон способен определить вклад каждого своего веса в суммарную

ошибку сети. Простейшее правило обучения соответствует методу наискорейшего

спуска, то есть изменения синаптических весов пропорционально их вкладу в общую

ошибку.

Рис. 2.4. Метод обратного распространения ошибки для многослойной

полносвязанной нейронной сети

Конечно, при таком обучении нейронной сети нет уверенности, что она

обучилась наилучшим образом, поскольку всегда существует возможность попадания

алгоритма в локальный минимум (рис. 2.5). Для этого используются специальные

приемы, позволяющие "выбить" найденное решение из локального

экстремума. Если после нескольких таких действий нейронная сеть сходится к тому

же решению, то можно сделать вывод о том, что найденное решение, скорее всего,

оптимально.

Рис. 2.5. Метод градиентного спуска при минимизации ошибки сети

.9.1 Обучение

с учителем

При обучении с учителем существует учитель, который предъявляет входные

образы сети, сравнивает результирующие выходы с требуемыми значениями, а затем

настраивает веса сети таким образом, чтобы уменьшить различия. Обучение с

учителем предполагает, что для каждого входного вектора существует целевой

вектор, представляющий собой требуемый выход. Вместе они называются обучающей

парой. Обычно сеть обучается на некотором числе таких обучающих пар.

Предъявляется выходной вектор, вычисляется выход сети и сравнивается с

соответствующим целевым вектором, разность (ошибка) с помощью обратной связи

подается в сеть, и веса изменяются в соответствии с алгоритмом, стремящимся

минимизировать ошибку. Векторы обучающего множества предъявляются

последовательно, вычисляются ошибки и веса подстраиваются для каждого вектора

до тех пор, пока ошибка по всему обучающему массиву не достигнет приемлемо

низкого уровня.

.9.2 Обучение

без учителя

Обучение с учителем критиковалось за свою биологическую

неправдоподобность. Трудно вообразить обучающий механизм в мозге, который бы

сравнивал желаемые и действительные значения выходов, выполняя коррекцию с

помощью обратной связи. Обучение без учителя является намного более

правдоподобной моделью обучения в биологической системе. Развитая Кохоненом и

другими, она не нуждается в целевом векторе для выходов и, следовательно, не

требует сравнения с предопределенными идеальными ответами. Обучающее множество

состоит лишь из входных векторов. Обучающий алгоритм подстраивает веса сети

так, чтобы получались согласованные выходные векторы, т.е. чтобы предъявление

достаточно близких входных векторов давало одинаковые выходы. Процесс обучения,

следовательно, выделяет статистические свойства обучающего множества и

группирует сходные векторы в классы. Предъявление на вход вектора из данного

класса даст определенный выходной вектор, но до обучения невозможно предсказать,

какой выход будет производиться данным классом входных векторов. Следовательно,

выходы подобной сети должны трансформироваться в некоторую понятную форму,

обусловленную процессом обучения.

Главная черта, делающая обучение без учителя привлекательным, - это его

"самостоятельность". Процесс обучения, как и в случае обучения с

учителем, заключается в подстраивании весов синапсов. Некоторые алгоритмы,

правда, изменяют и структуру сети, то есть количество нейронов и их

взаимосвязи, но такие преобразования правильнее назвать более широким термином

- самоорганизацией, и в рамках данной главы они рассматриваться не будут.

Очевидно, что подстройка синапсов может проводиться только на основании

информации, доступной в нейроне, то есть его состояния и уже имеющихся весовых

коэффициентов. Исходя из этого соображения и, что более важно, по аналогии с

известными принципами самоорганизации нервных клеток, построены алгоритмы

обучения Хебба.

Сигнальный метод обучения Хебба заключается в изменении весов по

следующему правилу:

(2.7)

(2.7)

где yi(n-1) - выходное значение нейрона i слоя (n-1), yj(n) - выходное

значение нейрона j слоя n; wij(t) и wij(t-1) - весовой коэффициент синапса,

соединяющего эти нейроны, на итерациях t и t-1 соответственно; a - коэффициент

скорости обучения. Здесь и далее, для общности, под n подразумевается

произвольный слой сети. При обучении по данному методу усиливаются связи между

возбужденными нейронами.

Существует также и дифференциальный метод обучения Хебба.

(2.8)

(2.8)

Здесь yi(n-1)(t) и yi(n-1)(t-1) - выходное значение нейрона i слоя n-1

соответственно на итерациях t и t-1; yj(n)(t) и yj(n)(t-1) - то же самое для

нейрона j слоя n. Как видно из формулы (2), сильнее всего обучаются синапсы,

соединяющие те нейроны, выходы которых наиболее динамично изменились в сторону

увеличения.

Полный алгоритм обучения с применением вышеприведенных формул будет

выглядеть так:

. На стадии инициализации всем весовым коэффициентам присваиваются небольшие

случайные значения.

. На входы сети подается входной образ, и сигналы возбуждения

распространяются по всем слоям согласно принципам классических прямопоточных

(feedforward) сетей[1], то есть для каждого нейрона рассчитывается взвешенная

сумма его входов, к которой затем применяется активационная (передаточная)

функция нейрона, в результате чего получается его выходное значение yi(n),

i=0...Mi-1, где Mi - число нейронов в слое i; n=0...N-1, а N - число слоев в

сети.

. На основании полученных выходных значений нейронов по формуле (2.7) или

(2.8) производится изменение весовых коэффициентов.

. Цикл с шага 2, пока выходные значения сети не застабилизируются с

заданной точностью. Применение этого нового способа определения завершения

обучения, отличного от использовавшегося для сети обратного распространения,

обусловлено тем, что подстраиваемые значения синапсов фактически не ограничены.

На втором шаге цикла попеременно предъявляются все образы из входного

набора.

Следует отметить, что вид откликов на каждый класс входных образов не

известен заранее и будет представлять собой произвольное сочетание состояний

нейронов выходного слоя, обусловленное случайным распределением весов на стадии

инициализации. Вместе с тем, сеть способна обобщать схожие образы, относя их к

одному классу. Тестирование обученной сети позволяет определить топологию

классов в выходном слое. Для приведения откликов обученной сети к удобному

представлению можно дополнить сеть одним слоем, который, например, по алгоритму

обучения однослойного перцептрона необходимо заставить отображать выходные

реакции сети в требуемые образы.

Другой алгоритм обучения без учителя - алгоритм Кохонена -

предусматривает подстройку синапсов на основании их значений от предыдущей

итерации.

(2.9)

(2.9)

Из вышеприведенной формулы видно, что обучение сводится к минимизации

разницы между входными сигналами нейрона, поступающими с выходов нейронов

предыдущего слоя y i(n-1), и весовыми коэффициентами его синапсов.

Полный алгоритм обучения имеет примерно такую же структуру, как в методах

Хебба, но на шаге 3 из всего слоя выбирается нейрон, значения синапсов которого

максимально походят на входной образ, и подстройка весов по формуле (2.9)

проводится только для него. Эта, так называемая, аккредитация может

сопровождаться затормаживанием всех остальных нейронов слоя и введением

выбранного нейрона в насыщение. Выбор такого нейрона может осуществляться,

например, расчетом скалярного произведения вектора весовых коэффициентов с

вектором входных значений. Максимальное произведение дает выигравший нейрон.

Другой вариант - расчет расстояния между этими векторами в p-мерном

пространстве, где p - размер векторов.

(2.10)

(2.10)

где j - индекс нейрона в слое n, i - индекс суммирования по нейронам слоя

(n-1), wij - вес синапса, соединяющего нейроны; выходы нейронов слоя (n-1)

являются входными значениями для слоя n. Корень в формуле (2.10) брать не

обязательно, так как важна лишь относительная оценка различных Dj.

В данном случае, "побеждает" нейрон с наименьшим расстоянием.

Иногда слишком часто получающие аккредитацию нейроны принудительно исключаются

из рассмотрения, чтобы "уравнять права" всех нейронов слоя.

Простейший вариант такого алгоритма заключается в торможении только что

выигравшего нейрона.

При использовании обучения по алгоритму Кохонена существует практика

нормализации входных образов, а так же - на стадии инициализации - и

нормализации начальных значений весовых коэффициентов.

(2.11)

(2.11)

где xi - i-ая компонента вектора входного образа или вектора весовых

коэффициентов, а n - его размерность. Это позволяет сократить длительность

процесса обучения.

Инициализация весовых коэффициентов случайными значениями может привести

к тому, что различные классы, которым соответствуют плотно распределенные

входные образы, сольются или, наоборот, раздробятся на дополнительные подклассы

в случае близких образов одного и того же класса. Для избежания такой ситуации

используется метод выпуклой комбинации [3]. Суть его сводится к тому, что

входные нормализованные образы подвергаются преобразованию:

=

=  (t) *

(t) *  (2.12)

(2.12)

где xi - i-ая компонента входного образа, n - общее число его компонент, α(t) - коэффициент, изменяющийся в

процессе обучения от нуля до единицы, в результате чего вначале на входы сети

подаются практически одинаковые образы, а с течением времени они все больше

сходятся к исходным.

Весовые коэффициенты устанавливаются на шаге инициализации равными

величине:

(2.13)

(2.13)

где n - размерность вектора весов для нейронов инициализируемого слоя.

На основе рассмотренного выше метода строятся нейронные сети особого типа

- так называемые самоорганизующиеся структуры - self-organizing feature maps

(этот устоявшийся перевод с английского, на мой взгляд, не очень удачен, так

как, речь идет не об изменении структуры сети, а только о подстройке синапсов).

Для них после выбора из слоя n нейрона j с минимальным расстоянием Dj обучается

по формуле (2.10) не только этот нейрон, но и его соседи, расположенные в

окрестности R. Величина R на первых итерациях очень большая, так что обучаются

все нейроны, но с течением времени она уменьшается до нуля. Таким образом, чем

ближе конец обучения, тем точнее определяется группа нейронов, отвечающих

каждому классу образов.

.9.3 Процесс

обучения нейронных сетей

Процесс обучения Искусственной Нейронной Сети (ИНС) новому классу задач

включает следующие стадии:

. Формулируется постановка задачи и выделяется набор ключевых параметров,

характеризующих предметную область.

. Выбирается парадигма нейронной сети (модель, включающая в себя вид

входных данных, пороговой функции, структуры сети и алгоритмов обучения),

наиболее подходящая для решения данного класса задач. Как правило, современные

нейропакеты, нейроплаты и нейрокомпьютеры позволяют реализовать не одну, а

несколько базовых парадигм.

. Подготавливается, возможно, более широкий набор обучающих примеров,

организованных в виде наборов входных данных, ассоциированных с известными

выходными значениями. Входные значения для обучения могут быть неполны и

частично противоречивы.

. Входные данные по очереди предъявляются ИНС, а полученное выходное значение

сравнивается с эталоном. Затем производится подстройка весовых коэффициентов

межнейронных соединений для минимизации ошибки между реальным и желаемым

выходом сети.

. Обучение повторяется до тех пор, пока суммарная ошибка во всем

множестве входных значений не достигнет приемлемого уровня, либо ИНС не придет

в стационарное состояние. Рассмотренный метод обучения нейроподобной сети носит

название "обратное распространение ошибки" (error backpropagation) и

относится к числу классических алгоритмов нейроматематики.

Настроенная и обученная ИНС может использоваться на реальных входных

данных, не только подсказывая пользователю корректное решение, но и оценивая

степень его достоверности.

2.9.4

Алгоритм секущих плоскостей